工具介绍

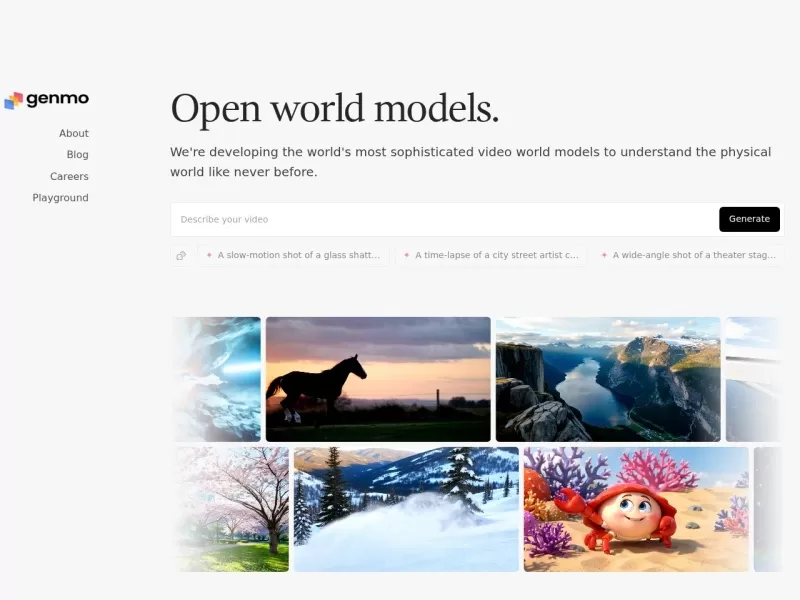

Genmo 是一家专注于视频世界模型研发的 AI 公司,致力于构建能够以前所未有的方式理解物理世界的复杂视频生成模型。其核心成果是 Mochi 1——一款前沿的开源文本生成视频模型,可将用户输入的文字概念直接转化为高质量、富有细节的动态视觉故事。Mochi 1 兼具易用性与可定制性,支持通过 GitHub 仓库或 ComfyUI 本地运行与二次开发,亦可在 Genmo 官方 Playground 在线体验。平台还展示了多种随机生成示例(如玻璃碎裂慢镜、街头艺术家绘制粉笔画、剧院后台准备场景),体现其对物理细节与镜头语言的精准把控。Genmo 的目标是推动生成式媒体迈向可理解、可交互的世界模拟,赋能创作者与研究者探索 AI 视频生成的新边界。

核心功能

- 文本生成视频:输入文字描述即可生成对应动态画面,支持复杂场景与细腻物理效果

- 开源模型 Mochi 1:可本地部署、定制与贡献代码,完全开放的研究与创作基础

- 多平台运行:支持通过 GitHub、Hugging Face 获取模型,兼容 ComfyUI 工作流

- 交互式 Playground:在线测试模型功能与生成效果,无需本地环境即可体验

- 物理世界理解:模型训练侧重对物体运动、材质反应、光影变化的真实模拟

- 示例随机生成:提供多种高质量演示案例,启发创作灵感

- 研究论文与更新:发布最新研究成果(如《Mochi 1: A new SOTA in open text-to-video》)

- 社区与协作:通过 Discord、GitHub、Hugging Face 形成活跃的开源社区

使用场景

- AI研究与学术:用于探索视频生成、世界模型、扩散模型等前沿课题

- 影视前期创意:快速将剧本或分镜文字转化为动态预览,辅助故事板制作

- 游戏与虚拟现实:生成游戏动画、环境演示或VR场景的动态素材

- 教育与科普:将抽象概念或历史事件转化为可视化视频,提升教学效果

- 创意短片与艺术:艺术家通过文字描述直接生成实验性或叙事性影像作品

- 内容营销与社媒:快速产出个性化视频素材,用于品牌故事或病毒式传播

适用人群

- AI研究员与开发者(优先):需获取开源视频生成模型进行实验与二次开发的科研人员

- 影视与动画前期策划:需快速验证创意视觉效果的导演、编剧、分镜师

- 游戏与VR开发者:需生成动态素材或原型演示的技术美术与策划

- 教育工作者与科普创作者:需将知识点转化为可视化视频的老师与作者

- 数字艺术家与创意实验者:探索文字到影像转化边界的艺术家

- 开源社区贡献者:希望参与前沿生成模型改进的程序员与爱好者

独特优势

- 世界模型定位:不仅生成视频,更致力于让模型理解物理世界运行规律,提升真实感与可控性

- 开源透明:Mochi 1 完全开放源码与模型权重,可本地运行、自由定制,避免闭源限制

- SOTA 性能:在开源文本生成视频领域达到先进水平,兼顾画质与语义匹配度

- 易用部署:提供一键安装脚本与详细文档,支持 GitHub、Hugging Face 快速获取

- 在线 Playground:零门槛体验模型能力,方便非技术用户快速测试创意

- 活跃社区:通过 Discord、GitHub 等平台汇聚全球研究者与创作者,持续迭代进步

- 跨领域应用潜力:从科研到艺术、从教育到营销,覆盖多场景需求

Genmo,...

Genmo,...